da Giorgio Bagnasco | Dic 29, 2021 | Presenza online

Ho letto qualche giorno fa la notizia di un episodio, che ritengo piuttosto grave, in cui un assistente vocale casalingo ha suggerito ad una bambina un’azione molto pericolosa: toccare con una moneta i poli di una spina della corrente inserita a metà. Colpevole è stata Alexa, l’assistente vocale tuttofare ormai presente in moltissime case; dopo l’accaduto Amazon ha aggiornato il software del suo device, per evitare che in futuro suggerisca sfide pericolose. Nel fatto citato l’intelligenza artificiale aveva proposto ad una bambina di provare la cosiddetta “penny challenge”, una sfida che consiste nell’inserire un carica batterie del telefono in una presa fino a metà e di toccare con una moneta i poli esposti. La bambina ha chiesto di partecipare ad una sfida che aveva trovato sul web e Alexa l’ha accontentata. Fortunatamente la madre si è accorta e ha impedito che accadesse qualcosa di grave, poiché i metalli conducono elettricità e inserirli in prese può causare incendi e folgorazioni mortali.

Perché ho riportato questo episodio? Perché i progressi in campo informatico stanno creando intelligenze artificiali sempre più performanti ma tra intelligenza e coscienza c’è un abisso. La discussione e le ipotesi sulla sua fattibilità hanno radici profonde, sin dal decennio 1940-1950, in cui un preveggente Isaac Asimov scrisse le 9 storie di “Io, robot”, una raccolta di racconti di fantascienza che ha per protagonisti dei robot positronici.

Nel libro la tematica principale è il timore che un giorno i robot, le macchine, possano sostituire l’uomo. L’autore esorcizza questa paura confidando nell’uomo che con la sua intelligenza, può fare molto di più ed è superiore ai robot. Con una lungimiranza quasi profetica, Asimov affermava con forza che l’uomo deve riuscire a mantenere questa superiorità e vivere la vita aiutato dai robot, ma solo in mansioni che questi possano svolgere senza dover prendere decisioni di tipo etico.

La mia domanda quindi è: un giorno i robot avranno una coscienza? E come la controlleremo? Dove porteranno le sperimentazioni sui circuiti ibridi fatti crescere su cellule nervose?

È un futuro intrigante, anzi inquietante, che ci fa dimenticare che la coscienza è un mistero per gli stessi esseri viventi, figuriamoci per una macchina. La capacità di sentire, di provare qualcosa, è riservata per ora agli organismi viventi dotati di un sistema nervoso complesso, perché essere coscienti vuol dire “sentire qualcosa”. Avere sensazioni prima fisiche, che diventano psichiche, vuol dire avere un sistema sensoriale e nervoso complessissimo, come solo quello umano rappresenta e per avere macchine che siano in grado di sentire, di elaborare ed esprimere risposte coscienti, sarà necessario un corpo che interagisca con l’ambiente e con altri simili.

L’efficienza delle interazioni di tipo sociale sarà ottenuta quando le intelligenze artificiali possiederanno una forma di coscienza fenomenica; provare qualche cosa e far diventare questo un modello, permetterà alle macchine di sentire gli altri e quindi immaginare i loro stati mentali. E quando questo avverrà, anche le interazioni sociali saranno diverse, perché non reagiranno semplicemente a quello che fa un’altra creatura ma la risposta sarà in virtù di comportamenti frutto di un’azione intenzionale: cioè che l’intelligenza artificiale prova e sente qualcosa: dolore, felicità, pensiero, convinzione, speranza.

Come non pensare al computer Al di “2001 Odissea nello spazio”, di Stanley Kubrick, in cui il computer di bordo dell’astronave uccide uno ad uno tutti i componenti dell’equipaggio, che si sono accorti di suoi comportamenti pensanti anomali?

Quando costruiremo macchine che capiscono che altre creature desiderano, allora sapremo che avranno evoluto la coscienza.

È un futuro entusiasmante ma che fa paura, noi informatici siamo abituati ad un meccanismo di causa effetto: programmiamo una macchina e gli insegniamo a fare delle cose, ma solo quelle e come conseguenza di un nostro input; qui si tratta di vedere agire macchine si costruite da noi, ma in grado, una volta create, di agire secondo una propria scelta, in base agli algoritmi di autoapprendimento sui quali si basano le applicazioni di Machine Learning.

Esperti di robotica hanno creato “macchine biologiche” in grado di riprodursi: gli xenobot capaci di comportarsi come semplicissimi organismi vitali: che siano gli antesignani di futuri organismi ibridi? Aspettiamo, considerando la velocità dei progressi in questo campo, dovrei riuscire a vederne i frutti.

In sintesi, qual è l’insegnamento che possiamo trarre da tutto ciò?

Che esiste un “effetto Matrix”, facendo riferimento alla popolare trilogia cinematografica? In effetti le cellule vivono una neuro-simulazione indotta da altri, quindi Matrix è una realtà a cui bisogna iniziare a credere sul serio?

Direi di no, perché nel caso di Matrix qualcuno dall’esterno ha creato la matrice e la realtà per gli esseri umani, per noi esseri umani reali, Matrix è semplicemente il risultato dei processi randomici della selezione naturale, perché tutto quello che sappiamo è frutto della raccolta dati di milioni di fibre nervose dall’ambiente circostante: calore, temperatura, pressione, dolore, piacere, che noi elaboriamo e traduciamo in azioni da inserire nel database dell’esperienza.

Volendo riferirmi ad una trilogia che amo molto: si, in un certo senso siamo già dentro Matrix, perché quando percepiamo qualcosa essa rappresenta la realtà ultima; l’immagine, la sensazione, l’emozione non sono altro che un’icona sullo schermo del mio computer mentale, quello che l’evoluzione di 500 milioni di anni ha prodotto affinché potessimo sopravvivere e continuare la specie. Quello che dovranno imparare a fare le macchine è esattamente questo. Ci riusciranno? Si! Quando? Non tra molto tempo ma auspico che dietro di esse resti sempre la nostra presenza e che la coscienza che li spinge ad agire sia la nostra, non la loro.

da Giorgio Bagnasco | Dic 15, 2021 | Sicurezza informatica

Noi che ci occupiamo di web siamo alla continua ricerca di metodi e azioni che permettano di mantenere le reti e i dati dei nostri clienti al sicuro. L’ormai imprescindibile presenza di internet e l’utilizzo dell’informatica nelle nostre vite e nelle nostre attività quotidiane, deve garantire che esse siano al sicuro da attacchi provenienti dal web ed è dovere di chi opera in questi campi, mettere in atto tutte le strategie professionali e tecniche, affinché questo avvenga. Da esperto del settore da ormai oltre venticinque anni, sono rammaricato di leggere di vulnerabilità dei sistemi e di rischio per i dati degli utilizzatori della rete; la notizia a cui mi riferisco sta tenendo banco in questi giorni ed è una di quelle che fanno tremare Internet: si è evidenziata una vulnerabilità in una libreria di Apache chiamata Log4j 2! Ah sì? direte voi, ma il problema è serio perché questa falla permette di attaccare una quantità enorme di servizi Internet e di aziende. In sostanza, quasi tutti i server e i prodotti informatici che usano Java sono attaccabili per il solo fatto di ricevere dati da Internet, senza che il pericolo che veicolano abbia bisogno di credenziali di accesso alla rete interna.

A lanciare l’allarme è stata l’Agenzia per la Cybersicurezza Nazionale, che ha diramato un comunicato in cui si parla di una: “vasta e diversificata superficie d’attacco sulla totalità della rete Internet” ed è più grave di quanto non si possa immaginare. Scoperta per caso da un ricercatore di Alibaba, il colosso del commercio online cinese, la falla consente ai criminali di far girare qualsiasi programma sui server che utilizzano Java. Il problema è che è molto semplice farlo, basta infatti un comando inviato ad hoc da un qualsivoglia programma per la navigazione Web e il danno è fatto.

Appena la vulnerabilità è venuta a galla, sono partiti una quantità imprecisata di attacchi, con conseguenze che si evidenzieranno solo nel corso delle prossime settimane. Inizialmente la maggior parte delle fraudolenze scoperte era mirata a creare cripto valute, il resto al momento ha obiettivi sconosciuti. Secondo Microsoft e Sophos, sono già stati lanciati attacchi attraverso Log4Shell, che hanno compromesso le reti aziendali con l’installazione di malware o programmi utilizzati per rubare credenziali di accesso. Sicuramente molti di questi attacchi infiltreranno nei sistemi informatici dei ransomware, causeranno furti di dati segreti con attività di spionaggio industriale e tentativi di frodi finanziarie. Il pericolo era conosciuto da tempo tra gli addetti ai lavori ma gli attacchi diventano ogni giorno più sofisticati; l’unico aspetto positivo della faccenda, è che i primi colpiti erano del tutto ignari, ora le aziende stanno cercando di correre ai ripari.

Purtroppo l’abilità dei criminali è in grado di eludere anche i sistemi protettivi messi in atto; pare che a pochi giorni dall’inizio delle violazioni, gli hacker stiano utilizzando modi meno diretti per sfruttare la vulnerabilità ed eludere le barriere erette per bloccarne i tentativi di accesso da chi sta cercando di arginare i danni. In poche ore sono state scoperte decine di varianti nell’utilizzo della falla, create per rendere più difficile smascherare le intrusioni. Devo dire purtroppo che la colpa del disastro sta nelle fondamenta fragile del castello internet.

Chi non mastica programmazione e creazione di reti, con tutto quello che ne consegue in termini di funzionalità e sicurezza, forse non ha la percezione dell’entità del danno e del pericolo che ne consegue; vi chiederete: “come è possibile che una funzione operativa dal nome sconosciuto ai comuni mortali, sia la colpevole di quello che è stato definito dagli addetti al settore, una catastrofe senza precedenti? Mi spiego: Log4J 2 è una libreria sconosciuta ai non informatici ma nota a chi sviluppa software in Java, il linguaggio di programmazione più usato oggi al mondo nei prodotti per il Web; lo scopo della sua creazione è tenere traccia di quello che succede sui server, annotando in un file di testo ogni operazione compiuta: il logging. Questa operazione automatica è utilissima perché rende semplice trovare eventuali errori di programmazione, malfunzionamenti e abusi. Paradossalmente però, Log4J 2, programma scontato sviluppato in open source, viene controllato e gestito da un numero esiguo di sviluppatori per i quali non rientra tra le priorità. Il pasticcio brutto di questi giorni ha messo in evidenza che il logging, una delle attività più importanti e più critiche per la gestione di servizi Web e dei prodotti ad esso connessi del pianeta, viene svolta da una libreria gratuita e programmata a tempo perso da sviluppatori volenterosi.

Quello che fa paura e sta rubando il sonno a noi informatici, è che la falla in Log4Shell è solo la punta dell’iceberg; sono infatti molte le programmazioni di piccole funzioni utili e facili date per scontate da tutti, gestite da pochissime persone, se non addirittura da una sola. Chiudere le porte della stalla quando i buoi sono scappati non può essere il modo di operare di chi opera nell’informatica e i tristi fatti di questi giorni devono farci ragionare in termini di prevenzione, strategie di organizzazione del lavoro e messa in sicurezza dei dati come attività imprescindibile per chi opera nel settore IT.

da Giorgio Bagnasco | Nov 23, 2021 | Sicurezza informatica

In questo periodo gli attacchi informatici di successo provengono dal web (80% del totale) e sfruttano comportamenti umani scorretti (oltre l’85% del totale). Nonostante la realtà preoccupante in termini di sicurezza, i sistemi progettati da molte aziende per proteggere da tali minacce non sono efficaci, poiché adottano un approccio statico, basato sulla reputazione delle pagine che vengono visitate. Da informatico con oltre 25 anni di esperienza nel settore, ho apprezzato particolarmente l’approccio che #ERMES propone per risolvere i continui attacchi ai dati; per spiegare nei dettagli che cosa è il prodotto di cui #IPSNet è partner nelle vendite, ho voluto rivolgere all’Ing. Hassan Metwalley, CEO di Ermes – Intelligent Web Protection, alcune domande:

Come nasce l’idea di Ermes?

Ermes nasce da un progetto di ricerca portato avanti tra Italia e Stati Uniti sul fenomeno dei web trackers. Alla base della ricerca, e di quella che è poi diventata Ermes – Intelligent Web Protection con gli sviluppi dei primi algoritmi di AI, l’intuizione del Prof. Marco Mellia del Politecnico di Torino: i grandi cambiamenti che stavano avvenendo nel web avrebbero modificato la natura degli attacchi cyber, spostandone il focus dalla rete aziendale al browser, passando quindi per l’essere umano.

Qual è lo scopo del prodotto?

L’obiettivo delle nostre soluzioni è quello di ridurre sensibilmente (di oltre il 30%!) l’esposizione delle organizzazioni agli attacchi hacker veicolati via web, oggi principale vettore di attacco con cui vengono colpite le aziende e che le soluzioni di sicurezza tradizionali non riescono a presidiare efficacemente. Gli attacchi che vanno a segno, infatti, fanno leva sull’interazione umana ed è necessario l’impiego dell’intelligenza artificiale per prevenire e bloccare sul nascere questa tipologia di attacchi, sempre più sofisticata.

In cosa è innovativo rispetto ad altri prodotti presenti sul mercato?

La nostra tecnologia è stata presa in oggetto dalle ricerche di Gartner proprio per il contributo che i nostri algoritmi di Intelligenza Artificiale portano nell’ambito della cybersecurity, permettendo di identificare quelle minacce che risultano invisibili alle altre soluzioni poiché non si imita a valutare la “reputazione” dei servizi web ma ne analizza il comportamento. Per spiegarlo con un esempio, è come se durante dei controlli in aeroporto, oltre a guardare il passaporto dei servizi web, Ermes li facesse passare sotto un metal detector. In questo modo, Ermes riesce ad evitare sia che i criminali accedano ad informazioni utili a costruire un attacco, sia che gli attacchi raggiungano effettivamente le vittime e vengano eseguiti. Inoltre è una soluzione on-device, complementare a qualsiasi sistema di sicurezza informatico e a differenza delle tradizionali soluzioni, che richiedono tempistiche e costi di attivazione non indifferenti, la protezione di Ermes è attivabile in pochi semplici passi, offrendo una migliore esperienza di navigazione per gli utenti ed una migliore performance dei dispositivi.

Come funziona la commercializzazione?

Riteniamo che la costituzione di collaborazioni con una rete di Partner qualificata, che sia vicina anche alle realtà che operano in ambito territoriale, sia necessaria per portare in maniera efficace e rendere accessibile la nostra soluzione sul mercato italiano. IPSNet si distingue per essere un punto di riferimento da oltre 20 anni per le aziende del territorio Piemontese, e riteniamo che attraverso questa unione sarà ancora più semplice facilitare il processo di digitalizzazione e la messa in sicurezza delle tante realtà che si affidano a loro.

Perché avere una adeguata protezione sul web è fondamentale per le aziende?

Il web negli ultimi anni si è distinto come principale vettore di attacco utilizzato dagli hacker per colpire organizzazioni di varia entità, non solo utenti privati. Basti pensare che l’80% degli attacchi hacker che hanno avuto successo hanno sfruttato proprio questo vettore. Il web risulta estremamente vulnerabile, poiché gli attacchi che vengono posti in essere strumentalizzano l’anello più debole della catena di sicurezza: le persone. Queste passano sempre più tempo online, sia per questioni lavorative che private, e navigano da diversi dispositivi e ubicazioni; questo rende difficile mantenere determinati standard di sicurezza.

Quali pericoli si corrono?

Gli attacchi hacker che avvengono sul web crescono esponenzialmente sia in termini di volumi, che per grado di sofisticatezza. Ogni giorno vengono creati oltre 200.000 nuovi siti di phishing (attacchi che non avvengono solo tramite Email, come erroneamente si crede) che spesso vivono per soli pochi giorni (o addirittura ore) e non riescono ad essere quindi identificati dalle soluzioni tradizionali. Inoltre, durante la navigazione, gli utenti lasciano inconsapevolmente delle tracce e informazioni che possono essere utilizzate da hacker per costruire attacchi su misura, in grado di trarre in inganno anche gli utenti più attenti, che vengono inconsapevolmente strumentalizzati per porre in essere le azioni criminali. Minacce ed attacchi con queste caratteristiche necessitano dunque del supporto dell’Intelligenza Artificiale per far sì che questi pericoli possano essere sradicati.

Grazie a tutte queste caratteristiche innovative e al supporto che l’azienda fornisce ai suoi dealer, #IPSNet, nel proprio ruolo di #SystemIntegrator e #ManagedServiceProvider, ha scelto l’innovativa soluzione di Intelligenza Artificiale #ERMES per la #Cybersecurity dei propri affezionati clienti.

Giorgio Bagnasco.

da Giorgio Bagnasco | Ott 18, 2021 | Presenza online, Uncategorized

Siamo nell’epoca del complottismo spinto, spesso si sente parlare di vaccini che contengono microchip, farmaci attivabili dal 5G e tentativi da parte dell’Ordine Segreto Mondiale di gestire le nostre menti. Non è questa di certo la sede per discutere di queste amenità, che rappresentano la mancanza di buon senso e l’anti scienza e parliamo invece di cosa l’informatica può fare a sostegno della medicina. È di queste ultime settimane la notizia della sperimentazione di un microchip inserito nel cervello di una 38enne americana, Sarah, da qualche anno gravemente affetta da una forma severa di depressione che non ha risposto alle cure tradizionali e che ora pare stia bene. La fonte della notizia è seria, è stata pubblicata su Nature Medicine e parla della stimolazione cerebrale personalizzata; si tratta di una tecnologia che impianta nel cervello di pazienti affetti da depressione grave un microchip alimentato a batterie.

È una specie di “pacemaker” per il Sistema Nervoso Centrale, un dispositivo capace di individuare i processi schematici dell’attività neurale, che corrispondono ai picchi di emozioni negative del paziente; la loro intercettazione produce l’invio di impulsi elettrici che regolano la produzione dei neurotrasmettitori che causano la depressione.

Sarah ha avuto un netto e sostanziale miglioramento dei sintomi già dopo 12 giorni, con successiva e repentina remissione della malattia. La paziente ha dichiarato di aver vissuto un piacevole e duraturo cambiamento della sua visione del mondo, il dispositivo ha tenuto a bada la sua depressione, permettendole di tornare a prendere in mano la propria esistenza.

Il metodo della stimolazione profonda del cervello era già usato per trattare il morbo di Parkinson, ora si affacciano interessanti applicazioni ad altre malattie neurologiche e psichiatriche; certo il metodo va affinato e soprattutto reso personalizzabile, perché ogni esigenza è specifica ed ogni paziente un caso a sé.

I microchip impiantati nella donna sono stati inseriti in due diverse regioni del cervello dopo aver eseguito un’attenta mappatura dell’attività cerebrale attraverso indagini strumentali. Il suo encefalo è stato sottoposto ai diversi stimoli per individuare la sede idonea all’innesto e dopo l’inserimento del chip Sarah ha iniziato a ridere di gran gusto, cosa che non accadeva da tempo.

Le due sedi sono quelle deputate alle emozioni e al meccanismo di ricompensa e nell’amigdala, il centro di integrazione dei processi neurologici superiori delle emozioni, coinvolta anche nella memoria emozionale. Questa zona dell’encefalo è anche attiva nel sistema di comparazione delle esperienze passate e nell’elaborazione degli stimoli olfattivi.

Il primo chip è stato in grado di “spegnere” gli stimoli nervosi che conducevano alla depressione, il secondo a “predire” quanto i sintomi si manifesteranno. Questo pacemaker da cervello non produce una stimolazione continua, ma è programmato per rilasciare uno stimolo ogni tot secondi e ogni volta in cui rileva un’attività elettrica legata alla depressione.

Per un informatico come me, leggere delle applicazioni in campo medico del mio lavoro mi riempie di orgoglio e di propositività verso le future ed infinite applicazioni che l’unione di questi due ambiti può produrre.

da Giorgio Bagnasco | Set 23, 2021 | Uncategorized

Recentemente Mark Zuckerberg, patron di Facebook, ha svelato quale sia il suo nuovo e ambizioso progetto: basta scontati sviluppi di applicazioni social e di hardware, nel futuro dell’azienda c’è lo spazio 3D, una materializzazione del virtuale internet, cioè un ibrido digitale e fisico definito “metaverso”.

Il termine è stato preso in prestito da un romanzo di fantascienza scritto nel secondo decennio del secolo scorso e del quale era il titolo.

In quell’opera la parola descriveva un futuribile spazio virtuale e tridimensionale, nato dalla confluenza di una realtà fisica virtualmente migliorata, in uno spazio digitale sempre attivo, in cui le persone reali coesistono simultaneamente indossando speciali cuffie e occhiali e possono interagire attraverso degli avatar.

In realtà prima di Zuckelberg ci ha pensato Steven Spielberg con il suo “Ready Player One”, bellissimo e realistico film sul futuro distopico che forse ci attende ma non vorrei offendere uno degli uomini più facoltosi del mondo, togliendogli il piacere dello scoop mediatico.

Gli lascio però il ruolo di divulgatore, perché da quando ne ha parlato lui, si sono accesi i riflettori sul metaverso, che è divenuto uno dei principali argomenti dibattuti tra gli addetti ai lavori e non solo, riguardo l’evoluzione di Internet e delle infrastrutture tecnologiche ad esso legate e sul ruolo delle attuali aziende leader. Evidentemente non si può non pensare al futuro di questo ambito ormai ma per adesso questa trasformazione è largamente inespressa e più legata a possibili e futuribili evoluzioni, che non a concreti modi di funzionamento. Per ora ci muoviamo tra previsioni e prospettive e la mia posizione scettica vista tra un po’ di tempo, forse mi farà apparire medioevale e provinciale, forse invece sarà sbagliata, perché risulterò incapace di cogliere la preveggenza del CEO di Facebook, staremo a vedere.

Le perplessità sull’argomento sono di certo dovute alla difficoltà a comprendere modelli e concetti ancora privi di riferimenti pratici.

Per rendere più comprensibile il discorso, è possibile citare alcune delle concezioni più comuni del metaverso derivate dalla fantascienza, in cui è raffigurato come una manifestazione della realtà di certo reale, scusate il calembour ma basata su un mondo virtuale, come nei film Matrix e Ready Player One appunto. In genere questi riferimenti ne esplicitano alcuni aspetti ma ne tralasciano altri, limitando la discussione ad un piano concettuale.

Per contro agli inizi degli anni ’80 era difficile prevedere e comunicare a chi non era del mestiere cosa sarebbe stato Internet oggi, allo stesso modo non sappiamo oggi come descrivere il metaverso che molto probabilmente vedremo in tempi non così lunghi.

I teorici di questa nuova realtà lo hanno stigmatizzato come costante, cioè un’esperienza senza interruzioni né possibilità di annullamento; sarà reale per tutti, pur permettendo la programmazione di eventi, come accade nella vita reale. Inoltre non porrà limitazioni al numero di utenti interconnessi.

Il metaverso avrà un risvolto commerciale ed economico impattante, perché individui e gruppi potranno creare, possedere, investire, vendere ed essere pagati per le loro prestazioni.

Questa nuova frontiera del web sarà sia digitale che fisica, sia disponibile sulle reti pubbliche che su quelle private, sia sulle piattaforme free che a quelle a pagamento. Dati, oggetti, risorse, contenuti saranno creati e gestiti da una grande varietà di contributori: individui, gruppi organizzati o imprese commerciali.

Le caratteristiche controverse e difficili da immaginare del metaverso porteranno di certo ad uno stravolgimento delle attuali regole e dinamiche dell’esperienza umana digitale, che oggi funziona come un mercato in cui ogni bancarella utilizza la propria valuta, i propri documenti e ha le proprie unità di misura.

I frequentatori del metaverso utilizzeranno un’unica identità digitale con un unico sistema generale, esso non sarà soltanto un «mondo virtuale» come può esserlo una piattaforma come Fortnite o Second Life, il sito Internet pensato per ospitare una seconda vita digitale.

Non sarà un gioco, né un hardware, né un’esperienza online. Sarà un mondo digitale fatto di dispositivi, servizi, siti Web, eccetera; funzionerà con un insieme di protocolli, tecnologia, canali e linguaggi, contenuti ed esperienze di comunicazione al di sopra di quell’insieme.

Sarà la porta di accesso alla gran parte delle esperienze digitali, una componente di quelle fisiche e la prossima piattaforma di lavoro?

Forse e se così sarà, produrrà un valore economico di migliaia di miliardi.

Lentamente il Metaverso modificherà il modo in cui distribuiamo e monetizziamo le risorse, man mano che prodotti, servizi e capacità tecniche si integreranno.

L’unico problema per ora sono le infrastrutture perché il metaverso richiede qualcosa che non esiste ancora. Internet non è stato progettato per sostenere la partecipazione di miliardi di persone in sincrono ed è strutturato con singoli server che comunicano tra loro in base alle necessità.

Ci sono aziende al lavoro da tempo per risolvere questo problema ma si tratta di una sfida epocale.

Occorrerà rivedere inoltre le regole sulla censura, sul controllo delle comunicazioni, sulle normative etc.

Insomma il dibattito sarà intenso e vedremo che cosa la tecnologia saprà fare, io, per quanto informatico, continuo a pensare che dobbiamo continuare a vivere all’aperto e incontrare le persone e il mondo che ci circonda in una realtà “reale”, se mi permettete il gioco di parole, lasciando quella “virtuale” in ambiti specifici e tecnici, noi possiamo ancora farlo. La tecnologia dovrebbe essere utilizzata per migliorare queste esperienze umane che ci accompagnano da milioni di anni, non per sostituirle.

Recentemente Mark Zuckerberg, patron di Facebook, ha svelato quale sia il suo nuovo e ambizioso progetto: basta scontati sviluppi di applicazioni social e di hardware, nel futuro dell’azienda c’è lo spazio 3D, una materializzazione del virtuale internet, cioè un ibrido digitale e fisico definito “metaverso”.

Il termine è stato preso in prestito da un romanzo di fantascienza scritto nel secondo decennio del secolo scorso e del quale era il titolo.

In quell’opera la parola descriveva un futuribile spazio virtuale e tridimensionale, nato dalla confluenza di una realtà fisica virtualmente migliorata, in uno spazio digitale sempre attivo, in cui le persone reali coesistono simultaneamente indossando speciali cuffie e occhiali e possono interagire attraverso degli avatar.

In realtà prima di Zuckelberg ci ha pensato Steven Spielberg con il suo “Ready Player One”, bellissimo e realistico film sul futuro distopico che forse ci attende ma non vorrei offendere uno degli uomini più facoltosi del mondo, togliendogli il piacere dello scoop mediatico.

Gli lascio però il ruolo di divulgatore, perché da quando ne ha parlato lui, si sono accesi i riflettori sul metaverso, che è divenuto uno dei principali argomenti dibattuti tra gli addetti ai lavori e non solo, riguardo l’evoluzione di Internet e delle infrastrutture tecnologiche ad esso legate e sul ruolo delle attuali aziende leader. Evidentemente non si può non pensare al futuro di questo ambito ormai ma per adesso questa trasformazione è largamente inespressa e più legata a possibili e futuribili evoluzioni, che non a concreti modi di funzionamento. Per ora ci muoviamo tra previsioni e prospettive e la mia posizione scettica vista tra un po’ di tempo, forse mi farà apparire medioevale e provinciale, forse invece sarà sbagliata, perché risulterò incapace di cogliere la preveggenza del CEO di Facebook, staremo a vedere.

Le perplessità sull’argomento sono di certo dovute alla difficoltà a comprendere modelli e concetti ancora privi di riferimenti pratici.

Per rendere più comprensibile il discorso, è possibile citare alcune delle concezioni più comuni del metaverso derivate dalla fantascienza, in cui è raffigurato come una manifestazione della realtà di certo reale, scusate il calembour ma basata su un mondo virtuale, come nei film Matrix e Ready Player One appunto. In genere questi riferimenti ne esplicitano alcuni aspetti ma ne tralasciano altri, limitando la discussione ad un piano concettuale.

Per contro agli inizi degli anni ’80 era difficile prevedere e comunicare a chi non era del mestiere cosa sarebbe stato Internet oggi, allo stesso modo non sappiamo oggi come descrivere il metaverso che molto probabilmente vedremo in tempi non così lunghi.

I teorici di questa nuova realtà lo hanno stigmatizzato come costante, cioè un’esperienza senza interruzioni né possibilità di annullamento; sarà reale per tutti, pur permettendo la programmazione di eventi, come accade nella vita reale. Inoltre non porrà limitazioni al numero di utenti interconnessi.

Il metaverso avrà un risvolto commerciale ed economico impattante, perché individui e gruppi potranno creare, possedere, investire, vendere ed essere pagati per le loro prestazioni.

Questa nuova frontiera del web sarà sia digitale che fisica, sia disponibile sulle reti pubbliche che su quelle private, sia sulle piattaforme free che a quelle a pagamento. Dati, oggetti, risorse, contenuti saranno creati e gestiti da una grande varietà di contributori: individui, gruppi organizzati o imprese commerciali.

Le caratteristiche controverse e difficili da immaginare del metaverso porteranno di certo ad uno stravolgimento delle attuali regole e dinamiche dell’esperienza umana digitale, che oggi funziona come un mercato in cui ogni bancarella utilizza la propria valuta, i propri documenti e ha le proprie unità di misura.

I frequentatori del metaverso utilizzeranno un’unica identità digitale con un unico sistema generale, esso non sarà soltanto un «mondo virtuale» come può esserlo una piattaforma come Fortnite o Second Life, il sito Internet pensato per ospitare una seconda vita digitale.

Non sarà un gioco, né un hardware, né un’esperienza online. Sarà un mondo digitale fatto di dispositivi, servizi, siti Web, eccetera; funzionerà con un insieme di protocolli, tecnologia, canali e linguaggi, contenuti ed esperienze di comunicazione al di sopra di quell’insieme.

Sarà la porta di accesso alla gran parte delle esperienze digitali, una componente di quelle fisiche e la prossima piattaforma di lavoro?

Forse e se così sarà, produrrà un valore economico di migliaia di miliardi.

Lentamente il Metaverso modificherà il modo in cui distribuiamo e monetizziamo le risorse, man mano che prodotti, servizi e capacità tecniche si integreranno.

L’unico problema per ora sono le infrastrutture perché il metaverso richiede qualcosa che non esiste ancora. Internet non è stato progettato per sostenere la partecipazione di miliardi di persone in sincrono ed è strutturato con singoli server che comunicano tra loro in base alle necessità.

Ci sono aziende al lavoro da tempo per risolvere questo problema ma si tratta di una sfida epocale.

Occorrerà rivedere inoltre le regole sulla censura, sul controllo delle comunicazioni, sulle normative etc.

Insomma il dibattito sarà intenso e vedremo che cosa la tecnologia saprà fare, io, per quanto informatico, continuo a pensare che dobbiamo continuare a vivere all’aperto e incontrare le persone e il mondo che ci circonda in una realtà “reale”, se mi permettete il gioco di parole, lasciando quella “virtuale” in ambiti specifici e tecnici, noi possiamo ancora farlo. La tecnologia dovrebbe essere utilizzata per migliorare queste esperienze umane che ci accompagnano da milioni di anni, non per sostituirle.

da Giorgio Bagnasco | Lug 11, 2021 | Uncategorized

Lo hanno definito il più grande attacco ransomware della storia, quello che il 4 luglio, giorno festivo negli USA, che partendo dall’infezione di Kaseya, società che fornisce sistemi di monitoraggio della rete, si è diffuso a centinaia di clienti di quest’ultima, mettendo a rischio milioni di pc. Il software di Kaseya, VSA, è stato colpito dal gruppo cybercrime REvil, una banda ransomware in gran parte composta da russofoni, già nota per attacchi mirati a importanti aziende (come i fornitori Apple), mediante un attacco sistematico che ha coinvolto oltre 1.500 aziende utilizzatrici di software dei clienti di Kaseya. Dal momento che questi gestiscono centinaia o migliaia di altre realtà, non è chiaro quanti saranno vittime del ransomware durante i prossimi giorni. Certo il numero è destinato a salire. Alcune delle aziende hanno già ricevuto richieste da 5 milioni di dollari per il riscatto dei dati, inoltre gli hacker vogliono 70 milioni di dollari (59 milioni di euro) in Bitcoin per rilasciare pubblicamente quello che chiamano un “decrittatore universale”. Il caso che ha tenuto banco sui giornali in Italia è quello del Gruppo Miroglio, i cui pc sono stati bloccati ed è stato chiesto un riscatto di 70 milioni di Euro.

Ma che cosa è un ransomware?

La risposta è nel nome stesso, che è composto dalla parola ransom – riscatto in inglese – e dal suffisso -ware, che lo identifica come programma malevolo, che sequestra i dati di un dispositivo chiedendo un riscatto per renderli nuovamente accessibili: insomma sono veri e propri virus informatici molto utilizzati dai cybercriminali per finanziare le loro attività illecite. Partita come una minaccia che puntava ad aumentare la quantità delle vittime, i ransomware sono stati utilizzati sempre di più fino a diventare delle attività molto più ragionate e mirate. A 32 anni dalla scoperta del primo ransomware noto come Trojan Aids o PC Cyborg il riscatto chiesto dai cybercriminali è aumentato di pari passo con l’evolversi delle tecnologie impiegate. Per consegnare un ransomware alle vittime, i criminali prediligono l’utilizzo di un popolarissimo e tristemente efficace vettore d’attacco: il phishing. Finte e-mail camuffate così bene da risultare autentiche e che inducono l’utente a cliccare su un link in esse contenuto, sono la porta d’accesso ai sistemi informatici bersaglio. Basta infatti un semplice click su un link malevolo per avviare il download del ransomware che, nel giro di pochi istanti, è in grado di criptare l’intero sistema rendendo il dispositivo infettato, completamente inutilizzabile.

Tutto questo spiega come rivolgersi a professionisti capaci aiuti a proteggersi dai cybercriminali.

da Giorgio Bagnasco | Giu 20, 2021 | Sicurezza informatica

Chi non è addentro ai meccanismi complessi che regolano il funzionamento delle reti informatiche e delle apparecchiature tecniche che le compongono, difficilmente ha la percezione di quanto siano delicate e suscettibili di blocchi o malfunzionamenti. Normalmente siamo convinti che inserire un gruppo di continuità elettrica sia sufficiente a preservarle, anzi tendiamo a credere che si auto controllino o addirittura che vivano di vita propria e si autorigenerino. E’ vero che ai non addetti ai lavori l’informatica pare sconfinare nella magia, del resto non è sempre tangibile il modo in cui opera e negli ultimi anni, con la virtualizzazione delle strutture e il cloud, sono sempre meno gli strumenti fisici che possiamo veder lavorare, ma non è così. Si tratta di reti complesse e sensibili che necessitano di controlli e test continui e in alcuni momenti dell’anno queste loro caratteristiche vengono messe a rischio dalle chiusure.

Abbiamo tutti una gran voglia di goderci le agognate vacanze, abbiamo le valige pronte sull’auto e non vediamo l’ora di partire, ma quando saremo nei nostri luoghi di relax, potremo dire di essere davvero tranquilli di aver lasciato in sicurezza e sotto controllo l’azienda? Purtroppo quando non si ha un monitoraggio diretto e continuo possono verificarsi imprevisti in nostra assenza, in grado di mettere a repentaglio il lavoro di mesi, a volte di anni. Potrebbe manifestarsi un inconveniente di alimentazione elettrica, un abbassamento di tensione, un fulmine che fa saltare i salvavita; potrebbe accadere che la rete informatica subisca un attacco da parte di hacker, che si rompa una tubazione e si produca una perdita idrica, potrebbe verificarsi un evento naturale straordinario e nessuno lo saprebbe. Al ritorno in azienda troveremmo un disastro, tutti i computer fermi, magari danneggiati e questo procurerebbe un grosso danno. Occorrerebbe dover riavviare tutti i sistemi, eventualmente sostituirne una parte, non potremmo riaprire subito e questo causerebbe una perdita economica.

Esiste un modo per ovviare a tutte queste nefaste conseguenze: attivare un sistema di controllo che sia i nostri occhi e le nostre orecchie in nostra assenza, non solo durante le vacanze ma anche nei fine settimana e durante le festività. Il monitoraggio della rete è un servizio che permette di avere un controllo completo dello stato dell’infrastruttura informatica e delle applicazioni, così da prevenire eventuali malfunzionamenti che potrebbero arrecare danni all’azienda. occorre mettere a punto un servizio continuo, economico e sicuro, che consenta di garantire l’integrità di tutti i dati e fornire il monitoraggio h/24 su guasti o problemi tecnici che possono danneggiare la rete informatica aziendale. In questo modo non si sarà più all’oscuro di ciò che accade durante l’orario di chiusura, in nostra assenza. Se si dovessero verificare problemi di ogni genere, il sistema di sorveglianza avvertirà e sarà possibile intervenire immediatamente, fisicamente con un addetto dedicato che può recarsi in loco, o da remoto, per ripristinare la piena funzionalità dei sistemi. Alla riapertura degli uffici nessuna cattiva sorpresa farà capolino dagli uffici e tutti gli addetti saranno operativi con i propri computer.

Solitamente si interviene dotando l’infrastruttura aziendale di programmi idonei, che interrogano ogni 5/10 secondi i dispositivi da monitorare e i dati raccolti vengono elaborati dalla piattaforma di gestione. Qualora i sistemi non rispondessero o si riscontrasse un disallineamento dagli standard predefiniti, un meccanismo di allerta e avvisi su cellulare e mail subentra in automatico. Questo permette l’intervento in tempo reale su anomalie o problemi di performance da parte del personale incaricato della gestione e della risoluzione dei problemi. In questo modo l’intera infrastruttura informatica ed i servizi erogati come siti web, applicazioni gestionali, servizi di posta elettronica, server, router, firewall, etc. sono continuamente gestiti senza alcuna conseguenza sulle attività degli utenti. Solitamente i servizi erogati da questi sistemi di controllo sono i seguenti:

- Presidio della rete: ogni sistema, server e applicativo è monitorato 24 ore su 24, 7 giorni su 7, 365 giorni l’anno.

- Help desk: il sistema di allerta coinvolge in tempo reale personale qualificato.

- Continuità operativa: il servizio di monitoraggio della rete garantisce la continuità operativa e la sicurezza informatica dell’organizzazione.

Insomma quando lasciamo la nostra azienda dobbiamo essere certi di poter dormire sonni tranquilli, sapendo che c’è chi se ne occupa in nostra assenza nel rispetto di una massima antica ma sempre valida, che prevenire è sempre meglio che curare! Buone vacanze a tutti.

da Giorgio Bagnasco | Giu 8, 2021 | Cloud, Uncategorized

Fin dalla sua uscita sul mercato nel lontano 1988, Microsoft Office è stato distribuito come un “prodotto“. Il software veniva acquistato per ottenere una licenza di utilizzo senza scadenza per quella versione; occorreva acquistare annualmente gli aggiornamenti. Il costo era elevato e ha portato allo spezzettamento delle versioni installate, causando problemi di compatibilità.

Negli ultimi anni, grazie alle connessioni veloci e al cloud, si è trasformato il “prodotto” in “servizio“, con l’avvento sul mercato di Microsoft Office 365, nuova versione cloud della suite office, che sostituisce il costo di licenza con un abbonamento, garantendo al cliente un servizio più economico, completo e sempre aggiornato all’ultima versione disponibile.

fa

Facciamo chiarezza

Office 365 è il servizio in abbonamento per l’utilizzo della suite Microsoft Office da non confondere con Microsoft Office Online, che è la modalità gratuita per usare i programmi Office mediante un browser web.

Disponibile in abbonamento mensile o annuale, nonostante sia nata per essere utilizzata online, questa suite è utilizzabile anche offline, essendo i file di installazione salvati in locale. I vantaggi sono: un numero maggiore di applicazioni incluse, minor costo e la possibilità di sfruttare 1 TByte di spazio OneDrive compreso nell’abbonamento.

Office 365 è digitale e non prevede l’acquisto di una versione materiale, non più dischi di installazione ma un abbonamento legato al proprio account Microsoft.

Al contrario di altre applicazioni cloud o web che necessitano di un server con cui dialogare, Office 365 installa in locale tutti i file e quindi è possibile lavorare in assenza di connessione dati.

In questo caso le funzionalità cloud saranno disattivate ma appena la connessione sarà ripristinata, la sincronizzazione automatica salverà in cloud. Questo permette di continuare a lavorare in assenza di connessione, per esempio in aereo e in caso di guasti alla linea Internet.

La suite Office 365 lavora con le versioni più recenti delle app di Microsoft Office Premium, come il client mail Outlook, il programma di videoscrittura Word, il foglio di calcolo Excel, OneNote come blocco note digitale e Powerpoint per la creazione di presentazioni. inoltre si aggiungono anche le App Access e Publisher, oltre al servizio di cloud storage OneDrive sempre incluso, che permette di archiviare in cloud fino a 1TByte di dati.

Completano il pacchetto a seconda delle versioni, Skype, Exchange, Sharepoint e Teams. Nell’abbonamento sono compresi gli aggiornamenti di sicurezza e le nuove versioni di tutte le app, senza obbligare l’utente all’acquisto di una nuova licenza per ogni nuova versione.

Per quanto riguarda le versioni non professionali, i prezzi spaziano dai 7€ al mese / 69€ all’anno, ai 10€ al mese / 99€ all’anno per la versione che permette l’utilizzo fino a un massimo di 6 utenti.

Il prodotto Business invece include una versione base da 4,20€ al mese che offre, oltre all’account e-mail Exchange, anche il servizio Teams per le riunioni virtuali ormai indispensabili a seguito del distanziamento sociale, uno spazio cloud OneDrive e le versioni web e mobili di tutte le applicazioni del pacchetto;

nella versione “Office 365 Apps” da 8,80€ più IVA al mese, si trovano solo le applicazioni Office ma non i servizi accessori (E-mail e Teams), ad esclusione di OneDrive; la versione più completa è la più gettonata “Office 365 Business Standard” da 10,50€ al mese più IVA, che comprende tutto il pacchetto business e le applicazioni per lo Smart Working (Teams, E-mail Exchange, OneDrive, SharePoint).

Per chi è adatto

Con Office 365 Microsoft offre un prodotto performante con numerosi vantaggi: più funzionalità e aggiornamento costante, con particolare attenzione alla crescente percentuale di utenti in mobilità e smart working che nell’ultimo biennio, per svariati motivi, costituiscono la fetta preponderante dei fruitori degli applicativi.

Questo nuovo modello di business può essere spiazzante per i vecchi utenti abituati alle licenze senza scadenza e all’acquisto di un prodotto, anziché di un servizio immateriale, ma il futuro sembra aver definitivamente virato verso il cloud e gli abbonamenti, portando vantaggi sia per le aziende che per i clienti.

IPSNet, forte della propria esperienza pluriennale nella fornitura di servizi IT assistiti, è in grado di accompagnare l’utenza in questo processo di migrazione e di nuova modalità di utilizzo del pacchetto Office, dalla creazione e gestione del tenant Microsoft (l’istanza aziendale da creare per poter acquistare il software Microsoft in modalità SAAS, Software As A Service) con tutte le implicazioni del caso (elenco utenti aziendali, tipo di servizi associati, scadenze, dimensione delle cassette postali e spazi di archiviazione documentale on line, alias, regole di inoltro dei messaggi ecc.). I tecnici IPSNet con un costante lavoro di ricerca e sviluppo, selezionano i migliori software per fornire servizi accessori aggiuntivi, ormai fondamentali per un corretto utilizzo della Suite Office 365 in termini di ottimizzazione del lavoro in team (Chat, Archiviazione e Ricerca di E-mail, Condivisione documentale), sicurezza e salvaguardia dei dati (Antivirus, Antispam, Backup).

Managed Services Specialist

Dottore in Matematica Informatica, originariamente sviluppatore di applicazioni Web, amministratore di database e project manager in una vasta gamma di applicazioni aziendali. Oggi specializzato in IT Management e System Integration, problem solving, progettazione e gestione di reti informatiche, ottimizzazione di sistemi informativi aziendali

da Giorgio Bagnasco | Mag 24, 2021 | Soluzioni ICT

Kubernetes: questo sconosciuto!

La parola ha radici lontane, nel greco antico infatti significava “nocchiere” o “pilota”.

Si tratta di una piattaforma open source sviluppata da Google come evoluzione del proprio sistema Borg, oggi utilizzata per la creazione e la gestione automatica dei container, cioè quegli ambienti software in grado di eseguire e isolare dall’esterno l’attuazione di processi e applicazioni informatiche.

Prima di addentrarmi nel racconto di che cosa è e fa la piattaforma, vorrei spiegare per chi magari non è così addentro ai tecnicismi informatici che cosa è un container e come funziona.

Che cos’è un container.

L’evoluzione informatica della funzionalità dei server è passata da un’architettura esclusivamente fisica ad una virtuale e, recentemente, alla virtualizzazione delle applicazioni e dei software, al fine di non sprecare potenze di calcolo e risorse, altrimenti spesso inutilizzate. La creazione dei container serve proprio a questo: perché virtualizzare un’intera macchina, quando è possibile farlo con una piccola parte di essa?

Questa intuizione ha spinto gli sviluppatori a trovare delle strade alternative alla virtualizzazione completa, così il team di Docker ha reso questa tecnologia uno standard, sviluppando un formato di containerizzazione capace di comprimere in blocchi le applicazioni ed effettuarne il deploy (rilascio al cliente di un sistema software o di un’applicazione) in qualsiasi ambiente di esecuzione, senza doversi preoccupare delle condizioni di eseguibilità. L’inserimento dei dati nei container può essere considerata figlia della virtualizzazione, da cui deriva, ma offre dei miglioramenti importanti.

Rispetto a un’intera macchina virtuale, un container offre:

un deployment semplificato: impacchettando un’applicazione in un singolo componente, che può essere distribuito e configurato con una sola linea di comando, senza preoccuparsi dell’ambiente di runtime (momento in cui un programma viene eseguito);

una disponibilità rapida: con la virtualizzazione e l’astrazione del solo sistema operativo e delle componenti necessarie all’esecuzione dell’applicazione, invece che l’intera macchina, il sistema si avvia in un tempo minore, rispetto a quello di una macchina virtuale;

un controllo più capillare: i container consentono agli operatori e agli sviluppatori di suddividere in pezzi ancora più piccoli le risorse computazionali, garantendo così un controllo superiore sull’eseguibilità delle applicazioni e un miglioramento delle prestazioni dell’intero sistema.

I vantaggi della containerizzazione sono diversi, tra cui l’opportunità per gli sviluppatori di possedere sul proprio laptop migliaia di container, e avere sempre a portata di mano un ambiente di deploy o test adatto a ciascuna applicazione in sviluppo. Su un laptop infatti è possibile eseguire diverse virtual machine, ma non in modo veloce e con limitazioni alle prestazioni esecutive, cosa invece possibile con i container. Inoltre la gestione dei cicli di rilascio delle applicazioni è semplice: per distribuire una nuova versione di un container occorre lo stesso tempo necessario a digitare una singola linea di comando in console.

La molteplice funzionalità, la portabilità tra i principali cloud provider e l’alta affidabilità, hanno reso il container uno degli strumenti al servizio degli sviluppatori più utilizzato per ottimizzare le risorse e creare un’infrastruttura performante.

Container vs macchine virtuali

Il vantaggio dei container rispetto alle virtual machine sta nella virtualizzazione delle applicazioni software dell’intera infrastruttura informatica. Poiché i container sfruttano il sistema operativo dell’host, invece del proprio, ne consegue che necessitano di risorse di elaborazione minime, oltre a essere più semplici da installare. Gli sviluppatori non devono intervenire per modificare tutta l’infrastruttura, ma gli è sufficiente agire sul singolo componente applicativo o processo. Da qui l’esigenza di un modello per governare automaticamente l’orchestrazione dei container distribuiti in cluster e su più server host.

La storia dei Kubernetes.

Quando, nel 2014, Google scelse questo nome per indicare la piattaforma open source per l’orchestrazione e la gestione di container, creata da Craig McLuckie e Joe Beda, scelse un logo rappresentato da un timone stilizzato, per richiamare l’origine greca e il significato della parola. I sette raggi del timone facevano riferimento al progetto Seven of Nine, che era all’origine di Kubernetes come ulteriore sviluppo di Borg. Nel 2015 Google, in seguito a un’alleanza con la Linux Foundation, decise di donare Kubernetes alla neonata Cloud Native Computing Foundation (CNCF), gruppo che aggrega i colossi mondiali del public cloud, insieme a un centinaio di startup. Il risultato attuale è un movimento globale che vede Kubernetes come uno dei principali tool di riferimento, con una crescita nell’utilizzo che i suoi fondatori non avevano ipotizzato neppure nei loro sogni più audaci. Nel 2019, infatti, aveva già più di 2.300 contributor e una diffusione capillare tra le imprese più innovative del mondo.

Come funziona Kubernetes

L’architettura e gli elementi chiave di Kubernetes rappresentano le ragioni del suo successo. La macchina master controlla i nodi (ognuno di loro rappresenta un singolo host di calcolo, cioè di macchina virtuale o fisica); essi lavorano controllati dal nodo master, che consente di programmare l’automatizzazione e la distribuzione dei container, in base ai desiderata dello sviluppatore e alla capacità di calcolo della macchina. Il software che riceve ed esegue gli ordini dal nodo master si chiama kubelet; esso avvia ed esegue i container. Gruppi di container riuniti in pod condividono risorse di calcolo e rete.

I vantaggi

La crescente fortuna di Kubernetes deriva dalla sua versatilità, visto il vasto numero di strumenti di supporto open source e la portabilità attraverso i principali cloud provider. Questo strumento innovativo è in grado di integrare i vari livelli di security con la stessa modalità con cui riesce a far interagire carichi di lavoro, reti, storage ecc., cioè mettendo a disposizione un’architettura di container completa. Questo vantaggio si riflette anche nel contenimento del rischio di downtime, perché la struttura della piattaforma assicura una continuità del servizio vicina al 100%.

Il futuro

Kubernetes permetterà la totale sincronizzazione delle app e questo porterà ad una distribuzione ottimale del carico di lavoro su tutti i cluster, grazie alla configurazione automatica dei server DNS. Insomma, tutto quello che sino a pochissimi anni addietro riguardava la fanta-informatica, oggi è realtà virtuale, mi si scusi il paradosso, che sta trasformando in maniera totale e irreversibile la concezione dei dati informatici e della loro gestione.

Buona navigazione a tutti!

Managed Services Specialist

Dottore in Matematica Informatica, originariamente sviluppatore di applicazioni Web, amministratore di database e project manager in una vasta gamma di applicazioni aziendali. Oggi specializzato in IT Management e System Integration, problem solving, progettazione e gestione di reti informatiche, ottimizzazione di sistemi informativi aziendali

da Giorgio Bagnasco | Mag 13, 2021 | Soluzioni ICT

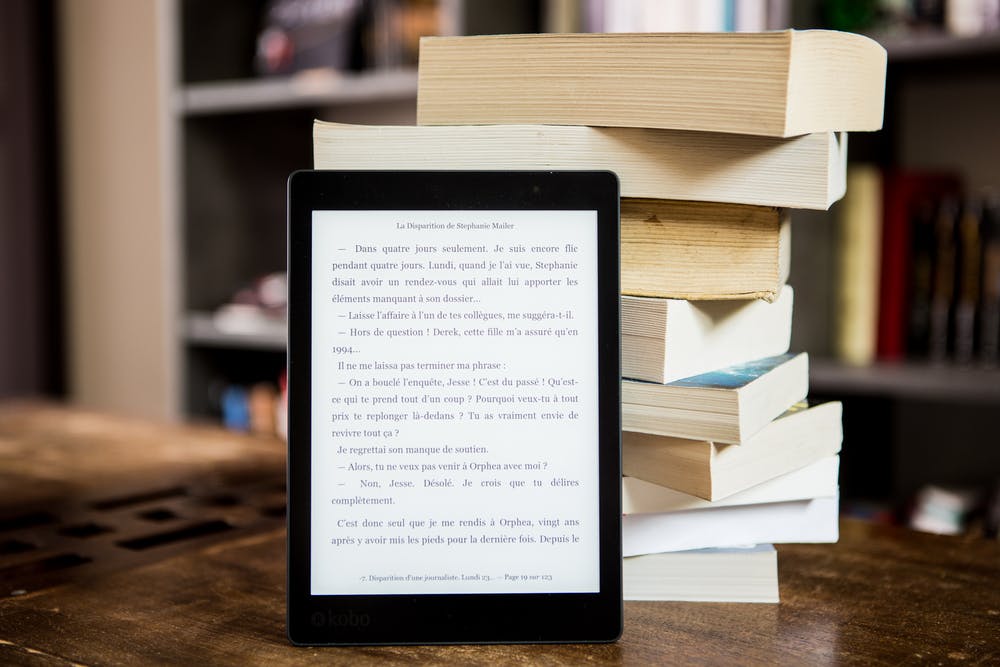

In questi ultimi due anni abbiamo imparato ad utilizzare, come mai prima, tutti gli strumenti informatici per sopperire all’impossibilità di incontrarsi di persona e frequentare luoghi pubblici. Così gli store dell’e-commerce hanno registrato crescite stratosferiche, il lavoro è diventato casalingo e da remoto, il cinema lo guardiamo sulle piattaforme, la scuola la frequentiamo in DAD e persino le cure mediche, le facciamo in telemedicina. Dopo il grande balzo in avanti del cinema on demand, il settore che è cresciuto di più è quello dei libri virtuali. L’incremento globale del settore è stato tra il due ed il tre percento sia per la chiusura di molti punti vendita, sia per la “reclusione forzata” che ha privato gli italiani di tante altre forme di intrattenimento e che si sono riscoperti ferventi lettori. Il cartaceo sostanzialmente ha tenuto, con le librerie che si sono trasformate in venditrici di servizi, oltre che di carta stampata, sia come valore complessivo, sia come numero di copie, mentre c’è stato un incremento del 36% degli ebook ed un raddoppio degli audiolibri. Rilevante il fatto che gli ebook, se in valore rappresentano il 6% delle vendite, in termini di copie sono al 13%, in quanto il prezzo medio è meno di metà. Il rapporto inoltre sottolinea come le vendite on line siano passate dal 27% al 43%, su base annua, ma con un picco nei primi trimestri, poi in parte riequilibrato.

Quindi il settore tiene, con l’aumento degli ebook, la crescita degli audiolibri e l’aumento delle vendite verso l’online. Ma ciascuno di questi fattori si manterrà stabile nel tempo o tornerà a livelli prepandemici? È presumibile che nel 2021 ed ancor più nel 2022, potendo ricominciare a viaggiare, a frequentare ristoranti, concerti, teatri, cinema, etc. gli italiani leggeranno un po’ meno, staremo a vedere. Così come non è chiaro quanto l’acquisto a distanza e la lettura dematerializzata siano ormai abitudini che il lockdown ha contribuito a consolidare. Per cercare di capire i possibili sviluppi dello scenario editoriale, valutiamo quali sono i modelli di business che Internet offre e come si sono evoluti altri settori di intrattenimento.

Prima fu la musica, si è sempre venduta su supporti fisici (LP e CD, che si vendono ancora, anche se sono diventati per collezionisti), poi con la dematerializzazione, la si inizia a distribuire gratis online: nasce Napster nel 1999, ad opera di Sean Parker. Le case discografiche gli fanno causa e lo fanno chiudere. I tempi non sono maturi. Oggi la musica si ascolta gratis con pubblicità su Youtube o Spotify o senza, pagando un abbonamento, sempre su Spotify (di cui peraltro Sean Parker è uno dei principali investitori). Quindi è la volta del cinema. Lo abbiamo visto per decenni nelle apposite sale, comodamente seduti su poltroncine, poi a casa con VHS e DVD. In un secondo momento i diritti venivano ceduti alle televisioni vecchia maniera. Oggi con la virtualizzazione ed una banda di trasmissione adatta, si guardano i film e gli altri prodotti video in streaming. Netflix ha iniziato la propria attività nel 1998 distribuendo DVD, con l’intento di portare il film a casa del cliente: poi col cambiamento della tecnologia, continua a portarli a casa ma dematerializzati. Disney, sempre in abbonamento, sta mettendo sulla sua piattaforma gli enormi archivi a sua disposizione, con Pixar, Marvel, I Simpson (Fox).

E i libri? Alle ormai stantie e banali considerazioni sul piacere fisico del maneggiare il libro, di sentire il rumore delle pagine girate e del loro profumo, che in realtà diventa polveroso dopo anni di scaffali o mensole, quanti di noi leggono ancora i quotidiani comprati in edicola? In effetti non è green e rispettoso delle future generazioni tagliare alberi per fare fogli di carta, stamparli, leggerli e cestinarli in giornata. Fortunatamente la tecnologia per dematerializzare i libri esiste da tempo, e ora è diventata semplice e poco costosa. Esiste un problema legato però alla virtualizzazione dei prodotti editoriali, il rispetto e la garanzia dei diritti d’autore. Gli ebook devono essere necessariamente protetti da un formato dato dalla piattaforma che pubblica: Amazon richiede l’acquisto del dispositivo Kindle, IBS si affida alla protezione DRM di Adobe, purtroppo i due sistemi non sono compatibili e creano una concorrenza sleale sul mercato. Per gli audiolibri sono disponibili piattaforme in abbonamento, ad esempio Storytel svedese o Audible di Amazon.

Osservando attentamente il mercato si nota che sono soprattutto i colossi ad usare queste piattaforme, mentre molti piccoli editori non vendono in formato elettronico i propri prodotti. Qui si ravvisa una monopolizzazione del mercato, poiché il proprietario della piattaforma pretende la fetta maggiore degli introiti, lasciando agli editori le briciole. Ad esempio Amazon chiede il 40% del prezzo di copertina sul cartaceo ed il 50% su un ebook, questo scoraggia gli editori che non possono contare su vendite a 5 cifre. Alla fine di questa carrellata che fotografa la situazione attuale, verrebbe da suggerire agli editori di mettere in rete in abbonamento i propri archivi sterminati di opere non più ristampate, convertendone alcune in audiolibri. Sarebbe bello vedere piattaforme flat della Mondadori, della de Agostini o della Einaudi! Staremo a vedere.

Managed Services Specialist

Dottore in Matematica Informatica, originariamente sviluppatore di applicazioni Web, amministratore di database e project manager in una vasta gamma di applicazioni aziendali. Oggi specializzato in IT Management e System Integration, problem solving, progettazione e gestione di reti informatiche, ottimizzazione di sistemi informativi aziendali

Commenti recenti